8 Minuty

Dyrektor generalny Nvidii ostrzega: zapotrzebowanie na moc obliczeniową AI eksploduje

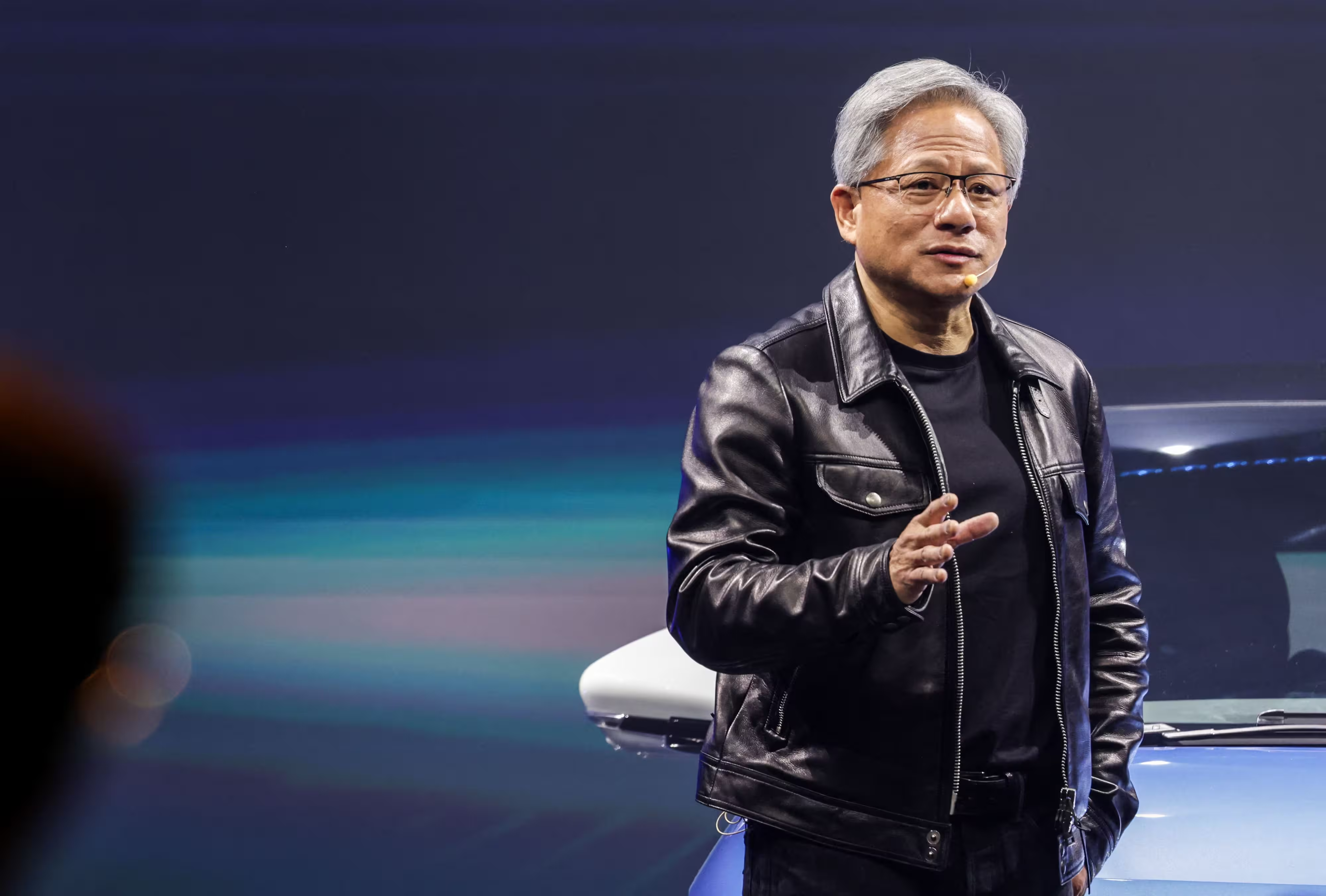

Podczas szeroko komentowanej, transmitowanej na żywo prezentacji w Las Vegas szef Nvidii, Jensen Huang, podkreślił, że wyścig o moc obliczeniową dla sztucznej inteligencji przybiera na sile. Popyt na układy GPU, specjalistyczne akceleratory AI i infrastrukturę centrum danych rośnie w szybkim tempie. Huang określił ten wzrost jako „intensywny wyścig” o osiągnięcie następnego etapu rozwoju sztucznej inteligencji, wskazując, że złożoność modeli oraz wymagania obliczeniowe rosną wykładniczo. Takie tempo zmian wpływa nie tylko na producentów chipów, lecz także na operatorów chmur obliczeniowych, dostawców rozwiązań HPC (High Performance Computing), firmy tworzące rozwiązania do uczenia maszynowego oraz przedsiębiorstwa inwestujące w transformację AI.

Wzrost zapotrzebowania na obliczenia wyprzedza podaż

Huang wyjaśnił, że rozmiary modeli AI i obciążenia treningowe zwiększają się w przybliżeniu o rząd wielkości co roku, co wymusza dramatyczny wzrost dostępnej mocy obliczeniowej. „Ilość obliczeń potrzebnych do napędzania postępów w AI gwałtownie rośnie. Popyt na układy Nvidia GPU gwałtownie rośnie,” stwierdził, podkreślając, że szybkość obliczeń bezpośrednio przyspiesza tempo przełomów badawczych i komercjalizacji modeli. W praktyce oznacza to większe zapotrzebowanie na jednostki obliczeniowe o wysokiej przepustowości pamięci (HBM - High Bandwidth Memory), szybsze interfejsy komunikacji (NVLink, PCIe Gen5/Gen6), a także na infrastruktury wspomagające, takie jak systemy chłodzenia cieczą, inteligentne zasilanie i rozwiązania zarządzania energią w centrach danych.

Skutki tej tendencji widoczne są na kilku płaszczyznach: producenci chipów muszą zwiększyć moce produkcyjne i zoptymalizować łańcuchy dostaw; operatorzy centrów danych muszą planować większe moce zasilania i pojemności chłodzenia w projektach RFP; a firmy korzystające z chmury muszą renegocjować modele kosztowe, by sprostać potrzebom treningu i inferencji modeli językowych oraz multimodalnych. Ponadto tempo wzrostu mocy obliczeniowej stawia nowe wyzwania w zakresie efektywności energetycznej — zarówno na poziomie chipu (performance per watt), jak i architektury systemowej (performance per rack i performance per datacenter).

Równie istotne są implikacje dla startupów zajmujących się AI oraz firm prowadzących badania nad modelami dużymi (Large Language Models). W miarę jak rosną wymagania obliczeniowe, koszty trenowania i wdrażania modeli stają się istotną barierą wejścia. To z kolei napędza rozwój rozwiązań optymalizacyjnych: kompresji modelu, kwantyzacji, technik transfer learning, a także dedykowanych akceleratorów i specjalizowanych bibliotek oprogramowania (frameworki zoptymalizowane pod konkretne instrukcje i tensor cores). W rezultacie ekosystem AI ewoluuje w stronę ściślejszej integracji sprzętu, oprogramowania i infrastruktury chmurowej.

Co to oznacza dla kopania kryptowalut i górników Bitcoin

Rosnące zapotrzebowanie na moc obliczeniową AI zaczyna przyciągać uwagę sektora kryptowalutowego. W ciągu ostatnich dwóch lat kilka firm zajmujących się kopaniem Bitcoina (BTC) częściowo lub całkowicie przekierowało swoją infrastrukturę na zadania związane z AI i obciążenia GPU. Zjawisko to wynika z kilku czynników: wzrostu trudności kopania Bitcoina, zmiennego przychodu z PoW (Proof of Work), a także możliwości osiągania wyższych lub bardziej stabilnych przychodów dzięki obsłudze zleceń związanych z treningiem i inferencją modeli AI. Dla operatorów, którzy zarządzają rozległą infrastrukturą centrów danych, dywersyfikacja usług jest logicznym krokiem — pozwala maksymalizować wykorzystanie sprzętu i optymalizować przychody z posiadanych serwerów, zasilania i chłodzenia.

Gdy zapotrzebowanie na moc obliczeniową AI rośnie, niektórzy górnicy Bitcoin mogą rozszerzać swoje portfolio sprzętowe o GPU i wyspecjalizowane akceleratory AI (np. dedykowane układy inferencyjne lub treningowe). Inni z kolei oferują wynajem wolnej mocy obliczeniowej podmiotom chmurowym lub firmom AI, co skutkuje rynkową rotacją zasobów między tradycyjnym kopaniem kryptowalut a usługami AI. Taka zmiana popytu może wpłynąć na dostępność GPU dla branży kryptowalutowej, zwiększając konkurencję o układy o wysokiej wydajności i przepustowości pamięci. W praktyce może to oznaczać, że okresy nadpodaży GPU, które wcześniej obniżały ceny kart graficznych, będą krótsze, a rynek wróci do bardziej zrównoważonej sytuacji z presją na wyższe ceny sprzętu o najwyższych parametrach.

Przekształcenia w wykorzystaniu sprzętu mają też znaczenie dla łańcucha energetycznego i kosztów operacyjnych. GPU wykorzystywane do treningu modeli AI często działają w trybie ciągłego, intensywnego obciążenia, co pociąga za sobą zwiększone zużycie energii, większe wymagania chłodzenia i inne koszty utrzymania. Dla firm wydobywczych, które operują na rynkach o relatywnie niskich kosztach energii, oferta wynajmu mocy obliczeniowej może stanowić atrakcyjną opcję biznesową. Może też przyspieszyć konsolidację między dostawcami infrastruktury chmurowej, operatorami centrów danych i firmami z sektora kryptowalutowego, które poszukują większej efektywności i stabilności przychodów.

Układy Rubin i Vera od Nvidii obiecują duże wzrosty wydajności

Huang przedstawił także plan rozwoju Nvidii, potwierdzając, że układy nowej generacji Rubin i Vera są już w pełnej produkcji i realizują harmonogram wprowadzania na rynek. Rubin i Vera zaprojektowano tak, by działały komplementarnie: jedno rozwiązanie zoptymalizowane pod konkretne etapy treningu i inferencji, drugie podłączone w modułowe systemy o zwiększonej gęstości obliczeniowej. Według deklaracji Nvidii, te układy mają zapewnić nawet do pięciokrotnego wzrostu wydajności obliczeń AI w porównaniu z poprzednimi generacjami. W praktyce oznacza to istotną presję na wzrost zapotrzebowania na moc zasilania centrów danych, skokowe zwiększenie zapotrzebowania na pamięć o wysokiej przepustowości (HBM3/4) oraz konieczność stosowania zaawansowanych rozwiązań chłodzenia, często opartych na chłodzeniu cieczą lub hybrydowych systemach ewentualnie z wykorzystaniem płyt Cold Plate.

Techniczne detale, na które warto zwrócić uwagę, obejmują ulepszenia w architekturze tensor cores, lepsze skalowanie przy wykorzystaniu połączeń NVLink oraz optymalizacje pod kątem pracy w klastrach wielowęzłowych. Rubin i Vera prawdopodobnie będą wykorzystywać innowacyjne techniki łączenia diesów (połączenia MCM — multi-chip module) oraz zaawansowane pakiety typu CoWoS/EMIB, co zwiększa przepustowość między chipami i redukuje opóźnienia. Z perspektywy wydajności na wat (performance per watt), kluczowe będą również usprawnienia w litografii, zarządzaniu zasilaniem i schematach DVFS (Dynamic Voltage and Frequency Scaling).

Skutki komercyjne tych układów są dalekosiężne. Przy pięciokrotnym wzroście wydajności szkolenia modeli, koszt jednostkowy trenowania dużych modeli może znacząco spaść, co z kolei może przyspieszyć rozwój nowych aplikacji AI. Jednak jednocześnie może się pogłębić luka między firmami dysponującymi dostępem do najnowocześniejszych akceleratorów a organizacjami bez odpowiednich zasobów kapitałowych czy dostępu do chmury. To zjawisko może napędzać dalszą konsolidację rynku chmury i usług AI, gdzie największe podmioty będą inwestować w najbardziej wydajne centra obliczeniowe i ekskluzywny dostęp do zaawansowanych układów Rubin i Vera.

Perspektywy: konkurencja, moce przerobowe i wpływ na sektor kryptowalut

Interakcja między rosnącym zapotrzebowaniem na moc obliczeniową AI a działalnością kopalni kryptowalut będzie się dalej rozwijać. Dla operatorów kopiących BTC kluczowym zadaniem może stać się balansowanie inwestycji między ASIC-ami zoptymalizowanymi pod Bitcoin (które oferują wysoką efektywność energetyczną w zadaniu PoW) a elastyczną infrastrukturą GPU/akceleratorów umożliwiającą realizację zadań AI. W dłuższej perspektywie strategia ta może stać się elementem zarządzania ryzykiem i dywersyfikacji przychodów, zwłaszcza w obliczu zmienności nagrody blokowej, opłat transakcyjnych i regulacyjnych czynników zewnętrznych.

Dla społeczności kryptowalutowej i projektów blockchain rosnące zapotrzebowanie na infrastrukturę AI może przełożyć się na zmiany kosztów hostingu, dostępności sprzętu oraz modele przychodów. Centra danych oferujące zarówno usługi chmurowe, jak i kolokację dla kopalni kryptowalut, będą w stanie proponować bardziej złożone umowy SLA, elastyczne modele cenowe i hybrydowe rozwiązania obciążeniowe. To może z kolei wpływać na konkurencyjność mniejszych graczy, którzy nie posiadają skali pozwalającej na negocjowanie korzystnych warunków z dostawcami energii i producentami sprzętu.

Podsumowując, przesłanie Nvidii było jasne: zasoby obliczeniowe są wąskim gardłem rozwoju AI. Firmy, które zabezpieczą najbardziej efektywną i wydajną moc GPU oraz akceleratorów AI, mogą szybciej osiągnąć kolejne przełomy technologiczne. To zjawisko ma realne konsekwencje dla branży AI, kopania Bitcoina i szerzej — dla ekosystemu kryptowalutowego. W miarę przyspieszania inwestycji w Rubin, Vera i pokrewne technologie, rynek będzie musiał zmierzyć się z wyzwaniami dotyczącymi dostępności sprzętu, kosztów energii, chłodzenia oraz strategii zarządzania infrastrukturą w skali przemysłowej. W rezultacie obserwujemy dynamiczne przesunięcie w kierunku integracji sprzętu, oprogramowania i infrastruktury, które razem determinują konkurencyjność firm na polu sztucznej inteligencji i przetwarzania danych na dużą skalę.

Źródło: cointelegraph

Zostaw komentarz