8 Minuty

Dlaczego nagłówkowe TPS często nie odzwierciedlają rzeczywistej skalowalności

Transakcje na sekundę (TPS) w kontekście blockchaina są powszechnie używane jako skrót do opisu wydajności, jednak podawane liczby rzadko oddają to, co rzeczywista, zdecentralizowana sieć może utrzymać. Wysokie wartości TPS są atrakcyjne w whitepaperach i materiałach marketingowych, lecz każda dodatkowa transakcja zwiększa obciążenie obliczeniowe i sieciowe węzłów, które utrzymują księgę rozproszoną. To napięcie — między surową prędkością wykonywania a kosztem decentralizacji — wyjaśnia, dlaczego teoretyczne TPS często załamują się, gdy łańcuch działa w środowisku produkcyjnym.

Testy porównawcze a sieci produkcyjne

Wiele wczesnych benchmarków lub testów przed uruchomieniem mainnetu mierzy TPS w idealizowanych warunkach: na jednym węźle lub w ciasno kontrolowanym testnecie. Takie warunki mierzą szybkość maszyny wirtualnej lub izolowany przepływ wykonywania, a nie pełną skalowalność sieci. Carter Feldman, założyciel Psy Protocol i były hacker oraz producent bloków, zauważa, że pomiary jednowęzłowe wprowadzają w błąd, ponieważ pomijają koszty przekazywania i weryfikacji transakcji w rozproszonej topologii.

"Wiele testów przed-mainnetowych, testnetowych lub izolowanych benchmarków mierzy TPS przy działającym tylko jednym węźle. W takim wypadku równie dobrze można nazwać Instagram blockchainem osiągającym miliard TPS, bo ma jedną centralną władzę walidującą każde wywołanie API" — powiedział Feldman.

Wykonanie to tylko część układanki

Profil wydajności blockchaina obejmuje wiele warstw: jak szybko maszyna wirtualna wykonuje transakcje, jak węzły się komunikują (przepustowość i opóźnienia), oraz jak liderzy i walidatorzy przekazują i potwierdzają dane. Benchmarki, które oddzielają wykonywanie od przekazywania i weryfikacji, mierzą coś bliższego przepustowości VM niż skalowalności sieci. W praktyce sieć musi zapewnić, że każdy węzeł pełny może zweryfikować transakcje i że nieprawidłowe dane są odrzucane — to właśnie gwarantuje decentralizację.

Nowe projekty reklamują wysokie TPS, choć użycie w sieci na żywo rzadko zbliża się do tych pułapów.

Przykłady historyczne: EOS i Solana

EOS publikował teoretyczny sufit TPS w milionach, jednak nigdy nie osiągnął takiego poziomu na mainnecie. Twierdzenia w whitepaperach o nawet ~1 milionie TPS przyciągały uwagę, lecz realistyczne testy i badania pokazały inny obraz. Testy Whiteblock i inne analizy w warunkach rzeczywistych wykazały spadek przepustowości do około 50 TPS w praktycznych warunkach sieciowych.

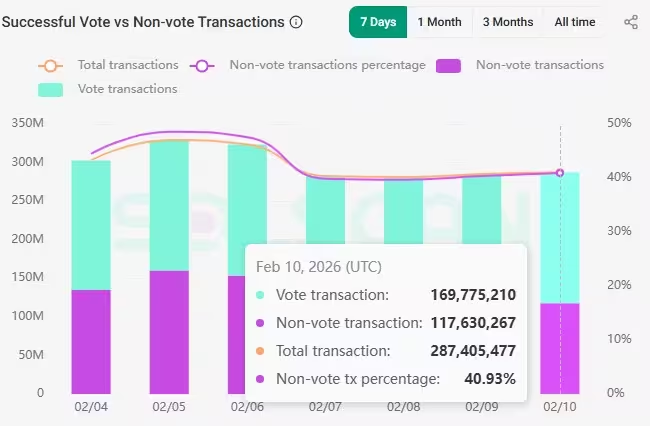

Bardziej niedawno klient walidatora Firedancer od Jump Crypto pokazał 1 milion TPS w kontrolowanych testach. To osiągnięcie potwierdza, jak daleko inżynieria potrafi wypchnąć prędkość wykonywania. Jednak sieć Solana w warunkach produkcyjnych typowo przetwarza w przybliżeniu 3 000–4 000 TPS; znacząca część tej liczby jest zużywana przez ruch związany z głosowaniami lub konsensem, a nie czyste transakcje użytkowników. Około 40% aktywności on-chain w danych Solany może stanowić ruch nienależący do transakcji użytkowników lub głosów, więc rzeczywista przepustowość skierowana do użytkownika jest niższa.

Solana zarejestrowała 1 361 TPS bez transakcji głosujących 10 lutego.

Te przykłady ilustrują powtarzalny wzorzec: izolowane rekordy wydajności nie są tym samym, co trwała przepustowość mainnetu, gdzie decentralizacja, propagacja sieci i koszty weryfikacji odgrywają kluczową rolę.

Problem liniowego skalowania i koszty decentralizacji

Przepustowość zwykle skaluje się liniowo z obciążeniem: dwa razy więcej transakcji to w przybliżeniu dwa razy więcej pracy. Ten liniowy związek staje się problemem, ponieważ każdy węzeł musi otrzymać i zweryfikować rosnącą ilość danych. Limity przepustowości łącza, ograniczenia CPU, operacje wejścia/wyjścia magazynu i opóźnienia synchronizacji w końcu tworzą twarde wąskie gardła. Gdy zwiększasz TPS bez zmiany modelu weryfikacji, zestaw maszyn zdolnych do uruchomienia węzła pełnego maleje, koncentrując władzę walidacyjną i osłabiając decentralizację.

Ten kompromis jest fundamentalny w wielu istniejących architekturach blockchain: surowe zyski TPS osiąga się kosztem różnorodności i geograficznego rozproszenia walidatorów. Zespoły projektowe często łagodzą presję poprzez podnoszenie wymagań sprzętowych, ale przesuwa to sieć w stronę mniejszego, bardziej profesjonalnego zbioru walidatorów.

Oddzielenie wykonywania od weryfikacji

Jednym ze sposobów zmniejszenia obciążenia na węzeł jest oddzielenie wykonywania od weryfikacji. Zamiast każdego węzła wykonującego wszystkie transakcje, węzły weryfikują zwarty dowód, że transakcje zostały przetworzone poprawnie. Podejście to obniża koszty weryfikacji dla zwykłych węzłów, jednocześnie koncentrując intensywną pracę na wyspecjalizowanych dowodnikach (proverach).

Feldman wskazuje dowody zerowej wiedzy (ZK) jako kluczowe narzędzie dla takiego projektu. Kryptografia zero-knowledge pozwala dowodnikowi przekonać weryfikujących, że partia transakcji została wykonana poprawnie, bez ujawniania wszystkich danych pośrednich lub wymagania, by każdy węzeł odtworzył każdą transakcję. To zmniejsza obciążenie weryfikacyjne, które musi ponosić każdy węzeł pełny.

Rekurencyjne dowody ZK i agregacja dowodów

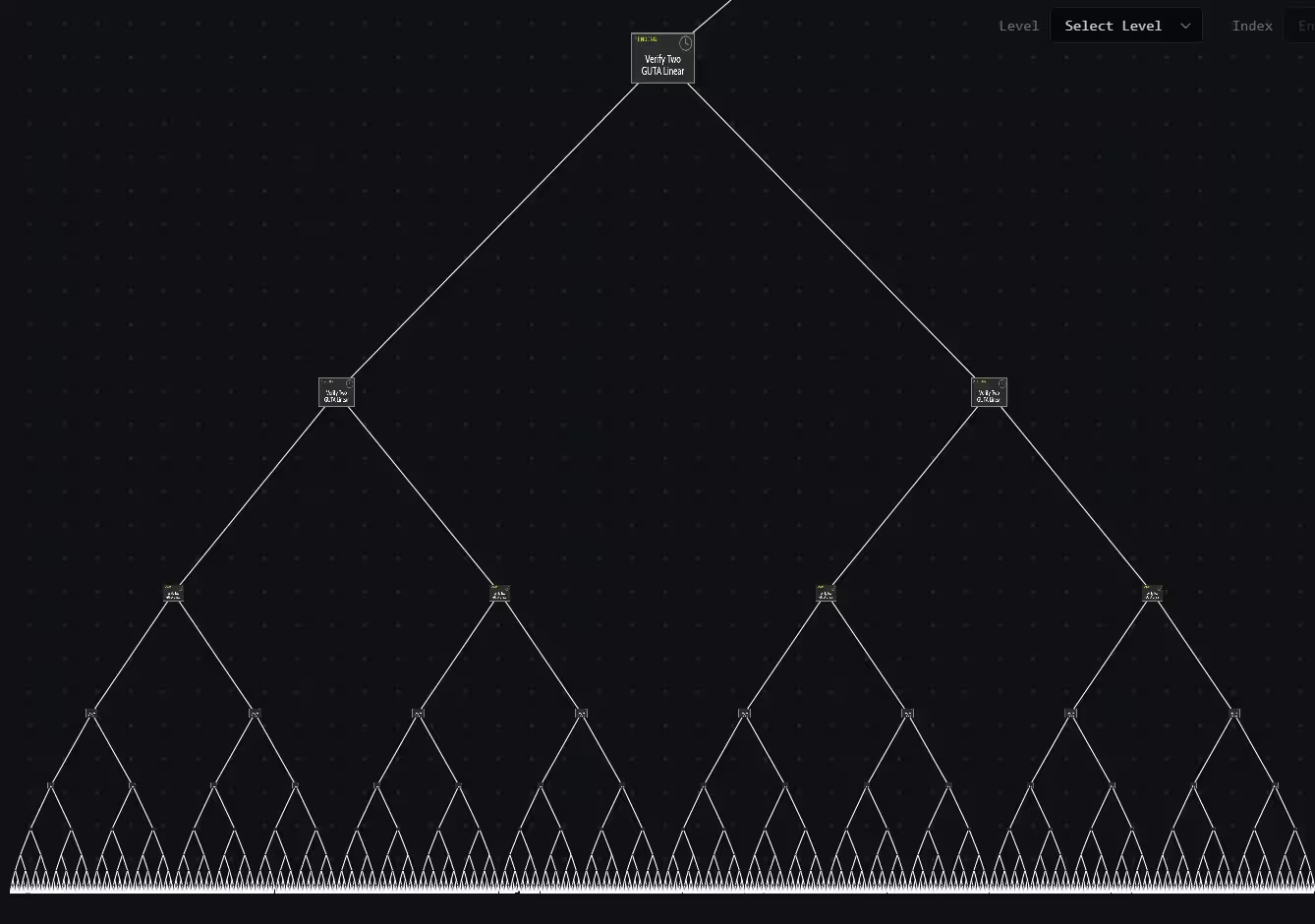

Rekurencyjne dowody ZK pozwalają łączyć wiele dowodów w pojedynczy dowód potwierdzający poprawność wielu wcześniejszych dowodów. Feldman zilustrował to drzewem dowodów: 16 transakcji użytkowników może stać się ośmioma dowodami, które następnie kompresują się do czterech, potem do dwóch i w końcu do jednego zwartego dowodu. Efektem końcowym jest jeden, mały artefakt potwierdzający poprawność dużej partii transakcji.

Jak kilka dowodów staje się jednym.

Wykorzystując dowody rekurencyjne, przepustowość może rosnąć bez proporcjonalnego wzrostu kosztów weryfikacji na węzeł. Oznacza to wyższy efektywny TPS na poziomie sieci, przy zachowaniu niskich kosztów walidacji dla zwykłych węzłów. Koszt jednak nie znika — przemieszcza się. Generowanie dowodów ZK może być obliczeniowo kosztowne i zwykle wymaga wyspecjalizowanego sprzętu lub infrastruktury. Ciężka praca jest przesuwana na dowodników, którzy, jeśli nie zostaną odpowiednio zaprojektowani, mogą się skonsolidować, co ponownie stwarza kompromisy z decentralizacją.

Dlaczego większość łańcuchów nadal korzysta z tradycyjnych modeli

Wdrożenie weryfikacji opartej na dowodach często oznacza przeprojektowanie podstawowych komponentów blockchaina: reprezentacji stanu, modeli wykonania oraz sposobu obsługi dostępności danych. Adaptacja walidacji opartej na ZK do konwencjonalnego EVM lub sekwencyjnego modelu wykonywania jest skomplikowana. To tłumaczy, dlaczego wiele ugruntowanych sieci nadal polega na tradycyjnym wykonywaniu i weryfikacji, mimo teoretycznych korzyści podejść ZK.

Feldman zwrócił też uwagę na historyczne mechanizmy finansowania: wczesni inwestorzy i zespoły faworyzowali projekty dopasowane do znanych modeli wykonania (np. łańcuchy kompatybilne z EVM). Budowa natywnego stosu wykonawczego opartego na ZK wymagała więcej czasu i nowatorskiej inżynierii, co początkowo utrudniało pozyskanie finansowania niektórym zespołom.

Wskaźniki wydajności poza surowym TPS

TPS jest użytecznym miernikiem, gdy jest używany poprawnie — mierzony w produkcji i uwzględniający koszty przekazywania i weryfikacji — ale nie jest jedynym wskaźnikiem zdrowia sieci. Metryki ekonomiczne, takie jak opłaty transakcyjne, zachowanie rynku opłat i średni czas finalizacji transakcji, oferują czytelniejsze sygnały popytu i pojemności. Blockchain o niskich opłatach pomimo wysokiego TPS w papierach może wskazywać na niewykorzystaną przepustowość, podczas gdy rosnące opłaty przy umiarkowanym TPS mogą sygnalizować przeciążenie i realne ograniczenia.

"Utrzymuję, że TPS jest drugim wskaźnikiem wydajności blockchaina, ale tylko wtedy, gdy jest mierzony w środowisku produkcyjnym lub w środowisku, gdzie transakcje nie tylko są przetwarzane, lecz również przekazywane i weryfikowane przez inne węzły" — podkreślił Feldman.

LayerZero Labs i inni twierdzili o dramatycznych sufitach TPS, łącząc innowacje wykonawcze z prymitywami ZK. Na przykład LayerZero promował łańcuch Zero twierdząc, że może skalować do milionów TPS dzięki technologii ZK. Te podejścia są obiecujące, ale ich długoterminowa zdecentralizowana wykonalność zależy od tego, jak generowanie i weryfikacja dowodów będą rozdzielone w sieci.

Praktyczne wnioski dla deweloperów i użytkowników

- Traktuj twierdzenia o TPS krytycznie: zapytaj, jak przeprowadzono testy i czy uwzględniono koszty przekazywania, przepustowości i weryfikacji.

- Preferuj benchmarki produkcyjne: pomiary mainnetu przy normalnym obciążeniu użytkowników mówią więcej niż dema przed-mainnetem.

- Obserwuj sygnały ekonomiczne: opłaty transakcyjne i zachowanie mempoola dostarczają praktycznych dowodów ograniczeń sieci.

- Oceń wpływ na decentralizację: wyższy TPS jest wartościowy, ale nie wtedy, gdy koncentruje walidację lub wymaga zaporowego sprzętu.

- Śledź postępy w narzędziach ZK: dowody rekurencyjne i agregacja dowodów mogą przełamać liniowy kompromis, ale wprowadzają własne kompromisy architektoniczne i ekonomiczne.

Podsumowanie

Nagłówkowe liczby TPS są atrakcyjne, ale niepełne. Rzeczywista skalowalność musi uwzględniać sposób rozgłaszania transakcji, ich weryfikacji oraz ekonomicznych zachęt w zdecentralizowanej sieci. Techniki takie jak oddzielenie wykonywania od weryfikacji oraz wykorzystanie dowodów zerowej wiedzy — zwłaszcza rekurencyjnych dowodów ZK — oferują obiecujące drogi do wyższej użytecznej przepustowości. Nadal jednak rozwiązania te przesuwają obciążenia, zamiast je eliminować, i wymagają starannej inżynierii, by zachować decentralizację. Na dziś najlepszym wskaźnikiem zdolności łańcucha do skalowania pozostaje przepustowość przetestowana w produkcji połączona z wskaźnikami ekonomicznymi, takimi jak opłaty i rozkład walidatorów.

Źródło: cointelegraph

Zostaw komentarz